到底一台服务器上最多能创建多少个TCP连接经常听到有同学说一台机器最多能创建65535个TCP连接,这其实是错误的理解,为什么会有这个错误的理解呢?

port range我们都知道linux下本地随机端口范围由参数控制,也就是listen、connect时候如果没有指定本地端口,那么就从下面的port range中随机取一个可用的 1" A9 f' k; [' }' u7 I, G) a1 W

2

% b8 r( T+ S/ s! r3 G- y7 U | # cat /proc/sys/net/ipv4/ip_local_port_range

. t' W# A% e" M9 b3 U$ m, S% `/ w2000 65535

$ J. u8 S6 T- e |

port range的上限是65535,所以也经常看到这个误解:一台机器上最多能创建65535个TCP连接 到底一台机器上最多能创建多少个TCP连接先说结论:在内存、文件句柄足够的话可以创建的连接是没有限制的(每个TCP连接至少要消耗一个文件句柄)。 那么/proc/sys/net/ipv4/ip_local_port_range指定的端口范围到底是什么意思呢? 核心规则:一个TCP连接只要保证四元组(src-ip src-port dest-ip dest-port)唯一就可以了,而不是要求src port唯一 后面所讲都遵循这个规则,所以在心里反复默念:四元组唯一 五个大字,就能分析出来到底能创建多少TCP连接了。 比如如下这个机器上的TCP连接实际状态: 1

2 d) m9 i4 A( k) p2

! i. x4 C o4 s! L; W% n6 W4 b3& W# d8 A5 Z( v. e' u* \

4- ~' W2 d+ \2 a

5' y1 c S, F, @: J7 w: a

6

* X* ?, h0 O+ n; n/ [ | # netstat -ant |grep 18089* z0 p3 Q/ |, G/ y+ v% ~ V& l

tcp 0 0 192.168.1.79:18089 192.168.1.79:22 ESTABLISHED

% F" {$ f5 H$ b: {tcp 0 0 192.168.1.79:18089 192.168.1.79:18080 ESTABLISHED

9 U+ z% b' B3 F5 Y4 P+ C; J9 o) O3 Etcp 0 0 192.168.0.79:18089 192.168.0.79:22 TIME_WAIT

+ z! n& y( S r! H4 T1 u0 ftcp 0 0 192.168.1.79:22 192.168.1.79:18089 ESTABLISHED& e( N/ y/ \1 @; Y+ c

tcp 0 0 192.168.1.79:18080 192.168.1.79:18089 ESTABLISHED

: T; ?$ e) N" `" _/ d$ y |

从前三行可以清楚地看到18089被用了三次,第一第二行src-ip、dest-ip也是重复的,但是dest port不一样,第三行的src-port还是18089,但是src-ip变了。他们的四元组均不相同。 所以一台机器能创建的TCP连接是没有限制的,而ip_local_port_range是指没有bind的时候OS随机分配端口的范围,但是分配到的端口要同时满足五元组唯一,这样 ip_local_port_range 限制的是连同一个目标(dest-ip和dest-port一样)的port的数量(请忽略本地多网卡的情况,因为dest-ip为以后route只会选用一个本地ip)。 那么为什么大家有这样的误解呢?我总结了下,大概是以下两个原因让大家误解了: - 如果是listen服务,那么肯定端口不能重复使用,这样就跟我们的误解对应上了,一个服务器上最多能监听65535个端口。比如nginx监听了80端口,那么tomcat就没法再监听80端口了,这里的80端口只能监听一次(如果有个连接用了80连别人,这里80还是不能被listen……想想)。

- 另外如果我们要连的server只有一个,比如:1.1.1.1:80 ,同时本机只有一个ip的话,那么这个时候即使直接调connect 也只能创建出65535个连接,因为四元组中的三个是固定的了。$ F6 B6 H5 Z! c! J- c2 A, @% ]

我们在创建连接前,经常会先调bind,bind后可以调listen当做服务端监听,也可以直接调connect当做client来连服务端。 bind(ip,port=0) 的时候是让系统绑定到某个网卡和自动分配的端口,此时系统没有办法确定接下来这个socket是要去connect还是listen. 如果是listen的话,那么肯定是不能出现端口冲突的,如果是connect的话,只要满足4元组唯一即可。在这种情况下,系统只能尽可能满足更强的要求,就是先要求端口不能冲突,即使之后去connect的时候四元组是唯一的。 但如果我只是个client端,只需要连接server建立连接,也就不需要bind,直接调connect就可以了,这个时候只要保证四元组唯一就行。 bind()的时候内核是还不知道四元组的,只知道src_ip、src_port,所以这个时候单网卡下src_port是没法重复的,但是connect()的时候已经知道了四元组的全部信息,所以只要保证四元组唯一就可以了,那么这里的src_port完全是可以重复使用的。 是不是加上了 SO_REUSEADDR、SO_REUSEPORT 就能重用端口了呢? TCP SO_REUSEADDR文档描述: SO_REUSEADDR Indicates that the rules used in validating addresses supplied in a bind(2) call should allow reuse of local addresses. For AF_INET sockets this means that a socket may bind, except when there is an active listening socket bound to the address. When the listening socket is bound to INADDR_ANY with a specific port then it is not possible to bind to this port for any local address. Argument is an integer boolean flag.

从这段文档中我们可以知道三个事: - 使用这个参数后,bind操作是可以重复使用local address的,注意,这里说的是local address,即ip加端口组成的本地地址,也就是两个本地地址,如果有任意ip或端口部分不一样,它们本身就是可以共存的,不需要使用这个参数。

- 当local address被一个处于listen状态的socket使用时,加上该参数也不能重用这个地址。

- 当处于listen状态的socket监听的本地地址的ip部分是INADDR_ANY,即表示监听本地的所有ip,即使使用这个参数,也不能再bind包含这个端口的任意本地地址,这个和 2 中描述的其实是一样的。

$ M1 j5 R. U: [5 ?) ~" T

==SO_REUSEADDR 可以用本地相同的(sip, sport) 去连connect 远程的不同的(dip、dport)//而 SO_REUSEPORT主要是解决Server端的port重用== What exactly does SO_REUSEADDR do? This socket option tells the kernel that even if this port is busy (in the TIME_WAIT state), go ahead and reuse it anyway. If it is busy, but with another state, you will still get an address already in use error. It is useful if your server has been shut down, and then restarted right away while sockets are still active on its port. You should be aware that if any unexpected data comes in, it may confuse your server, but while this is possible, it is not likely. It has been pointed out that “A socket is a 5 tuple (proto, local addr, local port, remote addr, remote port). SO_REUSEADDR just says that you can reuse local addresses. The 5 tuple still must be unique!” This is true, and this is why it is very unlikely that unexpected data will ever be seen by your server. The danger is that such a 5 tuple is still floating around on the net, and while it is bouncing around, a new connection from the same client, on the same system, happens to get the same remote port.

By setting SO_REUSEADDR user informs the kernel of an intention to share the bound port with anyone else, but only if it doesn’t cause a conflict on the protocol layer. There are at least three situations when this flag is useful: - Normally after binding to a port and stopping a server it’s neccesary to wait for a socket to time out before another server can bind to the same port. With SO_REUSEADDR set it’s possible to rebind immediately, even if the socket is in a TIME_WAIT state.

- When one server binds to INADDR_ANY, say 0.0.0.0:1234, it’s impossible to have another server binding to a specific address like 192.168.1.21:1234. With SO_REUSEADDR flag this behaviour is allowed.

- When using the bind before connect trick only a single connection can use a single outgoing source port. With this flag, it’s possible for many connections to reuse the same source port, given that they connect to different destination addresses.

7 p7 }( j# q2 W( f

TCP SO_REUSEPORTSO_REUSEPORT主要用来解决惊群、性能等问题。通过多个进程、线程来监听同一端口,进来的连接通过内核来hash分发做到负载均衡,避免惊群。 SO_REUSEPORT is also useful for eliminating the try-10-times-to-bind hack in ftpd’s data connection setup routine. Without SO_REUSEPORT, only one ftpd thread can bind to TCP (lhost, lport, INADDR_ANY, 0) in preparation for connecting back to the client. Under conditions of heavy load, there are more threads colliding here than the try-10-times hack can accomodate. With SO_REUSEPORT, things work nicely and the hack becomes unnecessary.

SO_REUSEPORT使用场景:linux kernel 3.9 引入了最新的SO_REUSEPORT选项,使得多进程或者多线程创建多个绑定同一个ip:port的监听socket,提高服务器的接收链接的并发能力,程序的扩展性更好;此时需要设置SO_REUSEPORT(注意所有进程都要设置才生效)。 setsockopt(listenfd, SOL_SOCKET, SO_REUSEPORT,(const void *)&reuse , sizeof(int)); 目的:每一个进程有一个独立的监听socket,并且bind相同的ip:port,独立的listen()和accept();提高接收连接的能力。(例如nginx多进程同时监听同一个ip:port) (a) on Linux SO_REUSEPORT is meant to be used purely for load balancing multiple incoming UDP packets or incoming TCP connection requests across multiple sockets belonging to the same app. ie. it’s a work around for machines with a lot of cpus, handling heavy load, where a single listening socket becomes a bottleneck because of cross-thread contention on the in-kernel socket lock (and state). (b) set IP_BIND_ADDRESS_NO_PORT socket option for tcp sockets before binding to a specific source ip

# U" ]+ K" [/ Z- `1 [with port 0 if you’re going to use the socket for connect() rather then listen() this allows the kernel

9 Z- L. L/ `* W W$ ~$ Y3 p( Eto delay allocating the source port until connect() time at which point it is much cheaper

The Ephemeral Port RangeEphemeral Port Range就是我们前面所说的Port Range(/proc/sys/net/ipv4/ip_local_port_range) A TCP/IPv4 connection consists of two endpoints, and each endpoint consists of an IP address and a port number. Therefore, when a client user connects to a server computer, an established connection can be thought of as the 4-tuple of (server IP, server port, client IP, client port). Usually three of the four are readily known – client machine uses its own IP address and when connecting to a remote service, the server machine’s IP address and service port number are required. What is not immediately evident is that when a connection is established that the client side of the connection uses a port number. Unless a client program explicitly requests a specific port number, the port number used is an ephemeral port number. Ephemeral ports are temporary ports assigned by a machine’s IP stack, and are assigned from a designated range of ports for this purpose. When the connection terminates, the ephemeral port is available for reuse, although most IP stacks won’t reuse that port number until the entire pool of ephemeral ports have been used. So, if the client program reconnects, it will be assigned a different ephemeral port number for its side of the new connection.

linux 如何选择Ephemeral Port有资料说是随机从Port Range选择port,有的说是顺序选择,那么实际验证一下。 如下测试代码: 1* }7 M r# V$ J! t! Z. s; Z; {9 ^3 i

2/ N) J# x* O# n9 Z) x& l. e$ \

35 J6 T, U. c: t- ^% i

4 h7 m% s: }' g* d& G$ u; m

5

* D$ J- G* H/ c& I6

/ A# G+ S1 O2 `/ T' e. V79 e9 Q! l+ R/ S# G& z# {

8, q) w9 S% b7 b$ f( I

9

5 h; F8 |2 J' y& w5 T- y102 ?0 L5 k7 y( l

11

8 a- |7 d' y3 m* k1 z/ A12

, s" z6 L c( N' |+ ^0 W13: m6 d0 q1 J: P

14

8 u/ ?3 Z% x9 o/ m8 _157 J9 A/ Y7 E- U5 I# G( p+ W

16& L# u. e, l! X" T* L2 ^

178 L% h& |+ p: I. b- O

18

$ H! ?& C& n. h/ j' \8 A2 V198 J0 a I! g( O# v0 P1 q8 f( B

20

& q: S) K& a/ J( S J21( M! R9 _, b, F' n. F' k8 H, l

22( y3 v$ G9 N2 k2 L4 `8 b1 d/ E r

23

: _% _. a5 q2 p1 D: {" \2 p$ \24& q1 H+ V; ?' S6 E

25

% }. \: |& i% o' J0 ?/ R0 Z) [+ `266 x8 ~9 G6 l+ w) u: J& J

27

5 h: q7 o) w6 i9 G28

0 J8 n: I) R& V! h3 k; b29

# k0 [( \" ]5 W0 Y3 d: Q30

5 Z( u' |/ m, l: D. I/ Y. ]5 J31

' J+ B5 v! _2 s- @0 C, t% d, j32

2 u/ P: X/ s$ `3 _/ X: E1 l4 L33

) R5 b/ @" f4 i34

* T0 N6 n8 ?& ~! S( s35, G W I) B" X7 [5 e$ L' Z

360 g4 ~/ g% B) J

376 [0 ?4 W @! o* i. |

38. l7 { ?) B1 {8 g& L8 G

39

! t) o' G8 V2 F. p4 O G40, |/ X3 f5 @# U* J1 Q% B" {, j

41' v& v& [7 O3 h; e. {

42

! d3 h) f+ o! b% T% X% A7 y' G | #include <stdio.h> // printf; w5 t0 D8 k. c9 c! {- T+ @8 S

#include <stdlib.h> // atoi

2 `" I1 z* L" F% S4 {; [1 W#include <unistd.h> // close

. l& S1 V6 t1 s. M! H5 F) W#include <arpa/inet.h> // ntohs/ f1 f% C: j' l- x9 c- Q! e

#include <sys/socket.h> // connect, socket4 i, d9 |7 G D: `* B

9 D- m$ t8 [* o3 I+ w6 U$ Avoid sample() {

2 b: z; u! |( n; }9 c' b // Create socket- Y E, n8 _" }4 r2 r

int sockfd;

/ A, _. O B- g/ Z8 w if (sockfd = socket(AF_INET, SOCK_STREAM, 0), -1 == sockfd) {, c1 p. i! }9 b8 ]: ^. A" a

perror("socket");# U! b; s" b6 @9 R7 \. C

}2 V0 d+ t5 h4 T

1 ^2 s: _6 s. X; h6 {7 L0 P* j! F$ P

// Connect to remote. This does NOT actually send a packet.% B, ~: M" S) ]8 ]8 w

const struct sockaddr_in raddr = {

' D& w* c' U+ | .sin_family = AF_INET,9 c0 ^) C8 R! V

.sin_port = htons(8080), // arbitrary remote port

0 a) j# b( q& D9 W .sin_addr = htonl(INADDR_ANY) // arbitrary remote host

. a* u. F* X6 p9 ?3 Z+ Q+ K };

, Z- V% K4 O" Y8 [& Y9 @ if (-1 == connect(sockfd, (const struct sockaddr *)&raddr, sizeof(raddr))) {* @8 N& @+ G$ W4 N) [" y) _4 D

perror("connect");

7 E; w9 w" S" ? }/ Q8 R# J* X, ~& C6 }8 R p. |7 j

0 \) A' y/ j N // Display selected ephemeral port% l( N# \# v6 _/ c9 ]$ r5 J

const struct sockaddr_in laddr;

3 }5 a8 E: Y9 Q3 r' a, D& n2 A socklen_t laddr_len = sizeof(laddr);

3 M0 l# c' x: q5 T6 k5 K$ v if (-1 == getsockname(sockfd, (struct sockaddr *)&laddr, &laddr_len)) {

5 Z2 o5 |1 s0 w5 z$ m+ ^ p0 O% f6 U perror("getsockname");' j4 G0 A" o+ r: H% j

}

: L) M9 z \- m: w; ] printf("local port: %i\n", ntohs(laddr.sin_port));

; l! p% N! Y! y5 g

. _ q$ y9 ~; d- r/ y. u // Close socket* W$ C. n2 T" x8 C0 K" F3 y

close(sockfd);. j0 d+ p( b% s9 C U% @

}

0 Z, k, c1 b3 m& o# {/ | S& G6 e3 n+ P; W ]$ G; g; i3 n

int main() {4 S1 t- \6 U9 n8 R; I$ w

for (int i = 0; i < 5; i++) {

2 H8 t) W& K" J; h5 z4 [ sample(); U. C1 N# l: G$ B$ J2 d

}

/ q& {$ |8 V1 ?- D! z, u5 d F) b+ z7 t! F! g

return 0;

$ v2 r1 n" o' e}6 Q7 e5 V7 |1 A+ K

|

bind逻辑测试代码 1# G1 }8 c3 S; O) e* d# l

2

# Z( T/ H% \' J2 w$ Z* H, P8 U3) s" w* r* H# \+ e H0 ?) w6 _+ z

4

) J, j1 T4 c5 ?- @* E y5 R& b" F5

( g4 r' |3 Z! o' u: Z64 ]" j0 z9 y- S) H3 c

7& [2 X5 h3 g2 J! {1 R( b

89 J1 _& ]. o' `$ ~/ g( v3 S

9, A6 I) H3 s* q& {

100 k) [/ B' x, g; H2 K

11

% i* B$ X6 C7 e& T1 h0 T$ b d# y12

" e; h6 [ K1 f* @7 c13

d, l5 @ w. e3 [144 ]: i6 v% X! E- t

155 k" v# @. ]% q Q/ E, k

16" r3 K5 d3 r) I* M, O

17% J: f+ p# P4 i; {

18 d4 p1 J$ L9 X; v+ A" D

19

; t. @2 K8 p. ~) }: z+ z20

S8 {8 I( p" p) a4 V! N21; P- z4 u# [" m0 o4 ?

220 R& P! \9 Q7 r ^

23

3 Y4 k# c% u2 u& w8 L. S f24

8 n* u' u8 k+ O! O: [25

& G9 P0 b/ Y6 ?' D% ]# M+ J26

3 f `' ~2 O9 ]( \% ~8 {$ v27

' D1 e& I' y' r; A. r: M. w1 C28- g% `" Z" p( j0 y. e

29 F; I$ i3 H9 r& T) o8 s9 h

303 C& G6 q, \" ~4 A2 M6 f2 m0 |% R

314 L3 `: _! h2 v6 [2 W* ]. g8 S& J7 \

32

- F/ q9 o1 b# Z. C33

6 s" N' M5 z' c, a34

3 E/ H- E! J8 G9 F2 e+ {8 J: C35

H7 p+ A7 o! C4 ~- v/ ?36" p6 S$ `! r; A* G3 y' |9 R% `

37" _" L" ^1 A; k" g( E; v, L: G' {2 g

38+ l' |: H1 W2 y4 ?+ y' N

39

% t: P: v; f/ C; T2 A& ^4 m400 Y( f1 ]" \5 t5 o. x

41

! |' {8 m# Q+ C3 z. ~! I, e3 d422 r! N0 x6 b& U3 O$ T

| #include <netinet/in.h>" @% @$ z& P$ @% F3 R9 b

#include <arpa/inet.h>/ q* |* Z. G& g' h# l

#include <stdio.h>

( h0 a$ P) l3 R#include <stdlib.h>

8 S& ~0 x# q3 _; M6 I#include <unistd.h>

% c& ?7 r' a0 k# ^! X; ] f#include <errno.h>

: o* C P$ ?' r/ ]#include <string.h>

0 S9 Y1 U% ^ W$ Q1 I#include <sys/types.h>8 _6 g: c- Q4 @, E) d; o' f6 C5 \9 n4 Q

#include <time.h>

% a/ ^3 Y6 @4 e1 ~/ r2 q" r, u1 ]8 d% _( W$ s7 c$ A- Y/ J& _

void test_bind(){

+ r* K# A# S6 F7 o$ c int listenfd = 0, connfd = 0;. j8 p/ Q' K& s! \8 |( i t

struct sockaddr_in serv_addr;0 ^0 r. n @( i. F

char sendBuff[1025];

" c8 o* m3 Q/ m/ P+ p time_t ticks;: I* y+ B& f* }# E( L

socklen_t len;

2 g. p3 R8 t3 y3 ?% K: T0 p# K& @2 M. d$ Q r. i. E

listenfd = socket(AF_INET, SOCK_STREAM, 0);

8 Y4 m( h+ \7 `8 e3 R( v, T- x memset(&serv_addr, '0', sizeof(serv_addr));

& E& c5 D1 i& S8 L5 I+ C memset(sendBuff, '0', sizeof(sendBuff));8 b# z& J2 o2 o4 {6 d& c

2 P" x! X3 r/ p* Y% _9 Y8 l3 u; X

serv_addr.sin_family = AF_INET;4 q4 C7 K( e+ n

serv_addr.sin_addr.s_addr = htonl(INADDR_ANY);

: D6 {) r' z. c9 n serv_addr.sin_port = htons(0);$ g& Z* m9 ^( f9 Q) O# i

4 \% I; ?) A0 Q% _$ j

bind(listenfd, (struct sockaddr*)&serv_addr, sizeof(serv_addr));& g2 e* ~% R R

. ^3 C' T6 I0 Q6 c

len = sizeof(serv_addr);

! O8 X' }# @3 y9 a if (getsockname(listenfd, (struct sockaddr *)&serv_addr, &len) == -1) {7 [. q: j/ W+ F! `9 ~2 A8 e' R

perror("getsockname");& a! o& T9 _8 |1 A) _

return;0 L3 m" a e: e5 F; i. `

}, N5 L2 w5 a/ \* ?. ^3 R

printf("port number %d\n", ntohs(serv_addr.sin_port)); //只是挑选到了port,在系统层面保留,tcp连接还没有,netstat是看不到的

3 ]0 {+ V" ]' g7 W) ?. [( G* u}8 Z [4 `% `& r C6 G5 Y, T# _

) \+ {* ~1 e9 {int main(int argc, char *argv[])! c& Y- o/ l0 a3 \) K2 E, f8 C

{( N; D3 c( w j/ O3 u7 S) j W

for (int i = 0; i < 5; i++) {

% f5 O7 a/ d9 q, Y test_bind();

* ]( A* H3 H" a }% G- { j0 l7 o

return 0;# F/ q, D& g0 @: ~

}% W9 g1 y2 a7 c6 t

|

3.10.0-327.ali2017.alios7.x86_64编译后,执行(3.10.0-327.ali2017.alios7.x86_64): 1

2 A) v6 m% }3 r5 h; B+ X23 I# P C- t' R& f3 Q$ I8 a

3

( q; x8 t0 I' C) v48 O" f7 X0 J6 t

5

! \3 n8 i- F1 w9 ]# \6$ V) A' _2 L1 | u" n# T

7

; i" |3 h3 p+ r) w8

3 ~' e/ ?$ `) \- Q2 W9

! m9 Y( M$ f& t X) m107 N0 ?1 T n o' r) _8 n

11* [* a/ v- O; P9 i- S& {3 F

126 H9 |6 k7 I$ b. @6 z& n

13

9 g) u% s2 n' T! j8 u14

8 ]5 a- b5 y. y156 M# H5 V' H. [" `' I. f* R

16! J4 r$ I$ O8 U \" h- G. Q

17

; z7 S# W7 S0 ~7 f: [5 D18# r$ x( e: v* G3 U; A7 V; j

19; ?7 G h# K9 E7 T! V

203 ^* q1 n0 V8 g& d) U9 q" b; T& [4 g

21

- j% c/ Y2 z( B4 p22

( U3 s+ L( L; v+ y23

# p+ S3 l" W5 H241 G$ g) G% {6 K1 ^* _

25' i9 P1 j) a, k9 I/ ~# p$ x( n) [! s

26

+ }4 G1 {6 h) ^* K3 X27 r- W( K' y3 i, f) ~; v

28

# b# K4 D5 e! b8 g* y2 F0 ?29

6 Y' _! Y4 }: o30

' P7 n" t) ]$ I+ z310 G( ~0 e# ~ F5 h$ V$ G; f

32

% _& E: f6 Y, \6 j0 @33- }' r7 r* t$ T8 e& c1 _

34

+ n4 P: P& l: Q# O# { i35

+ H( m1 b) s# h: y8 R36

4 u) i6 t0 }$ q37- O7 g7 f1 \; z' Y7 J4 B

| #date; ./client && echo "+++++++" ; ./client && sleep 0.1 ; echo "-------" && ./client && sleep 10; date; ./client && echo "+++++++" ; ./client && sleep 0.1 && echo "******"; ./client;. o/ O! `7 A4 r9 R

Fri Nov 27 10:52:52 CST 2020) r7 {3 a" t! E5 @ R* {

local port: 17448

9 }+ g6 F7 D3 O4 x# g+ Tlocal port: 17449

9 W8 m% |: e' D, E3 ylocal port: 17451 S5 f+ n5 C; W1 q2 ]

local port: 17452

. V& O, Q3 y6 g5 C0 T; ?local port: 17453

* b; n9 h$ w" r+++++++5 r4 M: w' G# p# }

local port: 17455

* ` u: L! K/ clocal port: 174562 U: T- r. }# d4 e& ?8 @

local port: 174572 F1 i4 f$ j; Y1 d! K$ a6 v' c

local port: 17458) s( M! k+ j, r

local port: 174603 q; P4 g- b& N9 Q: ^7 k, K! M, t4 Q

-------" Y5 x6 N6 N+ Y% w8 p, e/ J% e

local port: 17475! B- a2 H3 c' M: |; w* ?

local port: 17476

% Y" y ^9 I; {0 H+ slocal port: 17477! ^$ u5 \0 S( l, I/ i8 C4 i

local port: 17478

0 [$ z- H9 ]9 u5 C1 `* R# Tlocal port: 17479 d' Z' I0 ^' c. R3 B* n& }

Fri Nov 27 10:53:02 CST 2020

+ G L$ e( M! m/ w* Llocal port: 17997

2 ?3 \4 ^2 Y) n6 Klocal port: 17998

$ c4 A2 Z4 y# Llocal port: 17999; I. d3 N) I% H8 B

local port: 18000

9 D+ p& \& [8 E8 V8 x7 x0 elocal port: 18001

, s- C2 k" F: I/ G1 u2 k+++++++

- }- O1 B4 w" |, P! jlocal port: 18002

( u$ w1 h* f0 V( llocal port: 180032 B) `( @' R/ B. M2 b

local port: 18004

9 k) P+ ]# S* {) C$ flocal port: 18005" F2 R+ Y. W6 W! \+ S% n ]

local port: 18006* u5 q/ q% h( E7 ^& p2 ~

******

- N* m& o+ f: j- {) x, Mlocal port: 18010& _/ a- K/ V3 I

local port: 18011

& m& \* u6 X+ I6 e1 Dlocal port: 180122 E5 R/ q$ h, O2 [ Y" z+ S

local port: 18013$ e [! G0 a4 [' k3 b# k% B

local port: 18014

; o- S" l7 @) K9 P* A4 X6 ]; ~8 ] |

从测试看起来linux下端口选择跟时间有关系,起始端口肯定是顺序增加,起始端口应该是在Ephemeral Port范围内并且和时间戳绑定的某个值(也是递增的),即使没有使用任何端口,起始端口也会随时间增加而增加。 4.19.91-19.1.al7.x86_64换个内核版本编译后,执行(4.19.91-19.1.al7.x86_64): 1" O) K3 v$ l) K: W1 I7 r. Q

27 E. x5 ]% W- O; w% V4 E

3

: m5 e& r" F% m: i9 M4

0 N7 n* h, b; F2 @' u, M% C, Z5

: h4 H, x4 B. x( y. |; X& w6, q1 S: E/ b! Q: I" ?! M

7

5 P4 K0 i; I8 p0 F& s, S8- r: k; j+ {0 _9 r8 F' \

9

6 s- O' S6 U) E# k# A10

3 H, b9 ]6 Y7 K" ]/ b11

" r4 |( p9 Z# s5 @/ z, N12( A9 |2 L3 s& l5 P- S

13

3 U8 i8 x. p1 `9 N( c1 G3 d* k14# |! {' n) I6 t, u. m0 L% g

15: }1 l, t: L' B1 t5 D" I3 k) h

16

4 B$ ~, j/ [, H17

( p0 V0 U& r( G+ n$ [9 ]18

* \" t, r( D2 A. T8 b5 q" X- M19

4 X; r* L3 o2 M* m3 h/ l: V, r4 l20

' b( A7 Z& t6 C# r21

. J& ?" Y) B; X+ K3 R22

* C% _3 N. c b4 N. \1 _9 j' e23" N6 v8 `" D/ a# ^$ |9 |

24* H$ r7 \7 |( d! m$ m

25

0 S* f/ N3 S; W, j2 H26

6 p; Y$ ?* O. S1 O1 G( B27* t+ `$ Q5 N# ?! w, T

28! q6 N; }, a1 V% h2 o% C2 \) x

29

& @* W, b9 k( o3 l. v8 X306 l: e4 ]5 o. {" ]

31

! H& ~7 t: J) y32

) U1 L! e3 A2 A9 n( h33

1 ? J1 x+ z5 h( O' J0 W344 C# l0 v+ p( R4 p

35

; o7 w. \ p1 w+ @3 d$ m- h36

" k6 i( e) N8 s$ Z+ D37

" e+ y9 j5 m Q" \" M" b# E | $date; ./client && echo "+++++++" ; ./client && sleep 0.1 ; echo "-------" && ./client && sleep 10; date; ./client && echo "+++++++" ; ./client && sleep 0.1 && echo "******"; ./client;3 j' B6 U) |) E% Q8 |

Fri Nov 27 14:10:47 CST 2020

' r3 m2 I/ H# \0 h9 dlocal port: 7890+ y+ }$ H7 ?1 q% L! A

local port: 78922 E- ^/ C4 i# z- `! u" k# q

local port: 7894

' [9 u2 {+ H1 |- clocal port: 7896. m3 u, j8 _7 ~0 `

local port: 7898

+ J4 x9 w; T" R( k+++++++

6 x* l T; U/ P, f+ o- [local port: 7900 _( T7 a U" f0 u6 L

local port: 7902; h. S7 V* n4 n# |6 [8 W- a

local port: 79044 U8 P/ B9 n9 T+ u

local port: 7906

3 u! a6 g# |" nlocal port: 79081 k7 r# N- Z2 f Y

-------

- y4 P! s' K0 a0 D( l8 clocal port: 79106 ^: C) B2 D. L

local port: 7912

5 @1 d$ B6 ~9 z- V4 @local port: 7914

* L' O" t- _6 ?local port: 7916

, [! f8 R" d% M/ Elocal port: 7918

0 W X; ~ c; |8 y- p" n' qFri Nov 27 14:10:57 CST 2020+ w2 {, ^6 r- c, x# h5 M

local port: 7966

~3 |8 H3 W. C: m [4 a6 jlocal port: 7968; \1 g, L4 t! a" F$ P

local port: 7970

7 `3 S0 X9 g& {) V6 N- }& d( J$ klocal port: 7972 \$ B+ z1 E3 ~5 j& F" F

local port: 7974& z( C4 p& k. {: h/ T3 O. T P

+++++++

3 }; e& n/ P7 F. `local port: 7976. M+ n% Y2 i# o7 a) e! `" y

local port: 7978

7 ?; |2 D7 j7 ~% @1 M' i) q; ?local port: 7980

/ o4 k8 m4 S1 k, Q, C/ i' ?local port: 7982

{6 t) I' Y! v! @local port: 7984

, m6 j+ C, ?6 @! c******

- M: v" c8 s- G! L0 W) V$ clocal port: 7988. b' G! c& p: P% l- ~: _

local port: 7990

9 M& Z/ l$ j5 elocal port: 7992

& H. Q: h; v3 m/ u/ Xlocal port: 7994" J( G4 R0 Z9 U: r6 k" J

local port: 7996& r; p" p5 \+ v0 D

|

以上测试时的参数 14 {; a( `8 P5 I6 V2 `; f

2

( |" i3 }5 Y9 a, D | $cat /proc/sys/net/ipv4/ip_local_port_range

0 g) O( l2 }) ^) k- ]+ a: l7 y2 D1024 65535

, ~9 D0 a# [; u* @& |) c |

将1024改成1025后,分配出来的都是奇数端口了: 1# L8 A$ C4 Y6 G& i/ d

21 s' |) K6 |- X

30 J0 B6 A6 `* C( `- L

4

0 L9 ?# ]/ K/ I! i6 x5 M3 P' r v4 k5 y/ c. @

6( ^, F* l# n/ A8 ~0 j" F C2 V: X

7

6 N" X" q, e) U0 @8 j m; d8

+ ?5 ]8 D- k5 W2 a! t4 u90 c0 v1 l4 k/ E+ `( P

10

2 Y; U% ^, l0 S6 x% M11

2 d& Q5 v6 d P: {- v12

$ e5 v. Q7 v# L# L2 F13

U1 }( v0 ?- t o/ S14

6 p! W0 H/ t4 ]8 i5 _/ ]15' c% C. m1 M) \& L! D, |- J' h' G

16

" e2 l0 \, C1 S, h5 p! b172 ~- {- V. d0 [9 x4 w# M1 F$ @6 T

18( B2 I" I" V( L

19' t8 @1 h# U' q

| $cat /proc/sys/net/ipv4/ip_local_port_range

2 Q0 P- ] S- J1025 1034

# D- j. |2 \! B g& _

% }, O" t+ g- |/ J$./client1 u* U/ ?; T2 E6 s- R9 R

local port: 1033$ w$ P) u Z2 A, g: ]% m7 k

local port: 1025+ j! }' T2 D. I! ]) o; C

local port: 1027, U' G4 a# N1 Z9 q

local port: 1029; l" j/ d$ {& m' g6 R$ |" L4 X1 ]

local port: 1031

! \0 w6 R/ Y- _( olocal port: 1033

$ U9 h; y9 s2 v& J5 x3 m6 hlocal port: 10253 l* Q2 E, V- F( \1 c0 O2 }

local port: 1027

+ _5 O( G# ?: f5 ~* d( blocal port: 1029

5 `: R& l# Z( a$ z4 n$ ~' ~1 zlocal port: 1031

) _) g: i [( _* Z. |5 ^& Olocal port: 1033' [3 c8 w. {: L6 O

local port: 1025' }" y* E5 r7 m

local port: 10277 } q8 b8 J; \4 w4 m

local port: 10296 T4 K1 N9 Z% }4 x1 L

local port: 1031

$ l- v! v) C( c |

之所以都是偶数端口,是因为port_range 从偶数开始, 每次从++变到+2的 原因,connect挑选随机端口时都是在起始端口的基础上+2,而bind挑选随机端口的起始端口是系统port_range起始端口+1(这样和connect错开),然后每次仍然尝试+2,这样connect和bind基本一个用偶数另外一个就用奇数,一旦不够了再尝试使用另外一组 1

9 [. Y" k* v7 ~1 @& M22 [" s9 l" R# ?$ ?! ]

38 D- c4 {" \% z# z" M6 u

4

! I- N9 D( [- [- Z7 d) L2 f5+ N& P' m8 P" F5 ]

67 E& G; t/ b9 @3 r) p0 [

7' {/ ]( I* m+ S+ G: g# {/ m' S

81 a( H. `6 U Z0 ?

9( c$ A) U6 a7 S9 K0 k/ m

10

' C0 b$ z; u, u: z7 D+ k0 S115 O$ g5 } s$ I8 T8 c% i. Q* u. \$ q

12/ U$ e* ~! N& z. e( j2 s

132 `% D2 W0 x0 H2 f. A

148 b4 X% G; O& z- O5 _

15

" y Z% {2 [8 \16( d7 M: \4 i- m7 W* _/ V

17+ ?! ?9 K. V+ j+ l

| $cat /proc/sys/net/ipv4/ip_local_port_range+ I; V, u2 [$ }6 _% R- l

1024 10472 k' B8 V" m( n0 W' `

. A1 d& U+ r4 E* a" u) s

$./bind & ---bind程序随机挑选5个端口+ [. F3 U+ V8 k

port number 10399 _7 D$ G X* r8 s

port number 1043$ o" o/ M7 w1 D8 j% ?) E7 |

port number 1045

$ }& k6 m- [6 j# t0 _3 E& L5 Vport number 1041* H2 Q' K* o& e; I F& \3 T4 G$ }

port number 1047 --用完所有奇数端口4 I! `/ r3 Y7 H9 {

, M6 ~8 F) R, G; U+ L

$./bind & --继续挑选偶数端口0 T$ ?4 e% `1 j- l3 b+ y

[8] 4170% M0 e/ A0 Q' q: v4 Y

port number 10445 e% m3 P$ z8 T& o# G: j

port number 1042

+ \2 |5 m. Y% L& W" hport number 1046! o* F9 I& a$ E/ \8 ?, E

port number 0 --实在没有了

7 d- A7 z6 T; x. u: l! Rport number 0( t: M' J+ m5 e; ]) y1 ~

|

可见4.19内核下每次port是+2,在3.10内核版本中是+1. 并且都是递增的,同时即使port不使用,也会随着时间的变化这个起始port增大。 Port Range有点像雷达转盘数字,时间就像是雷达上的扫描指针,这个指针不停地旋转,如果这个时候刚好有应用要申请Port,那么就从指针正好指向的Port开始向后搜索可用port tcp_max_tw_bucketstcp_max_tw_buckets: 在 TIME_WAIT 数量等于 tcp_max_tw_buckets 时,新的连接断开不再进入TIME_WAIT阶段,而是直接断开,并打印warnning. 实际测试发现 在 TIME_WAIT 数量等于 tcp_max_tw_buckets 时 新的连接仍然可以不断地创建和断开,这个参数大小不会影响性能,只是影响TIME_WAIT 数量的展示(当然 TIME_WAIT 太多导致local port不够除外), 这个值设置小一点会避免出现端口不够的情况 tcp_max_tw_buckets - INTEGER* R' g/ d# A+ N% g

Maximal number of timewait sockets held by system simultaneously.If this number is exceeded time-wait socket is immediately destroyed and warning is printed. This limit exists only to prevent simple DoS attacks, you must not lower the limit artificially, but rather increase it (probably, after increasing installed memory), if network conditions require more than default value.

SO_LINGERSO_LINGER选项用来设置延迟关闭的时间,等待套接字发送缓冲区中的数据发送完成。 没有设置该选项时,在调用close() 后,在发送完FIN后会立即进行一些清理工作并返回。 如果设置了SO_LINGER选项,并且等待时间为正值,则在清理之前会等待一段时间。 如果把延时设置为 0 时,Socket就丢弃数据,并向对方发送一个 RST 来终止连接,因为走的是 RST 包,所以就不会有 TIME_WAIT 了。 This option specifies how the close function operates for a connection-oriented protocol (for TCP, but not for UDP). By default, close returns immediately, but ==if there is any data still remaining in the socket send buffer, the system will try to deliver the data to the peer==.

SO_LINGER 有三种情况 - l_onoff 为false(0), 那么 l_linger 的值没有意义,socket主动调用close时会立即返回,操作系统会将残留在缓冲区中的数据发送到对端,并按照正常流程关闭(交换FIN-ACK),最后连接进入TIME_WAIT状态。这是默认情况

- l_onoff 为true(非0), l_linger 为0,主动调用close的一方也是立刻返回,但是这时TCP会丢弃发送缓冲中的数据,而且不是按照正常流程关闭连接(不发送FIN包),直接发送RST,连接不会进入 time_wait 状态,对端会收到 java.net.SocketException: Connection reset异常

- l_onoff 为true(非0), l_linger 也为非 0,这表示 SO_LINGER选项生效,并且超时时间大于零,这时调用close的线程被阻塞,TCP会发送缓冲区中的残留数据,这时有两种可能的情况:2 L4 C" Z0 M0 t" R4 x0 s

- 数据发送完毕,收到对方的ACK,然后进行连接的正常关闭(交换FIN-ACK)

- 超时,未发送完成的数据被丢弃,连接发送RST进行非正常关闭9 t& A/ k: }1 O; \# g9 {3 C

1

) n j' y" Y1 R9 h* O2$ w+ F: T* ~1 M) s

30 c# ^- W9 ?* j, |- \

4

4 u8 d) [4 z% l; b2 S0 ?: u8 O | struct linger {

3 ], k, X) M$ P6 o) ~8 } int l_onoff; /* 0=off, nonzero=on */

& z( i, z' w, Y: I8 J int l_linger; /* linger time, POSIX specifies units as seconds */- U8 a5 K! M: N

};

" g- w* g" B3 V Y, b3 A, s |

NIO下设置 SO_LINGER 的错误案例在使用NIO时,最好不设置SO_LINGER。比如Tomcat服务端接收到请求创建新连接时,做了这样的设置: 1

+ J$ l5 W7 M: a" q; J! b5 a: X | SocketChannel.setOption(SocketOption.SO_LINGER, 1000)

6 A; Y% P$ U7 k- y- T/ j2 f |

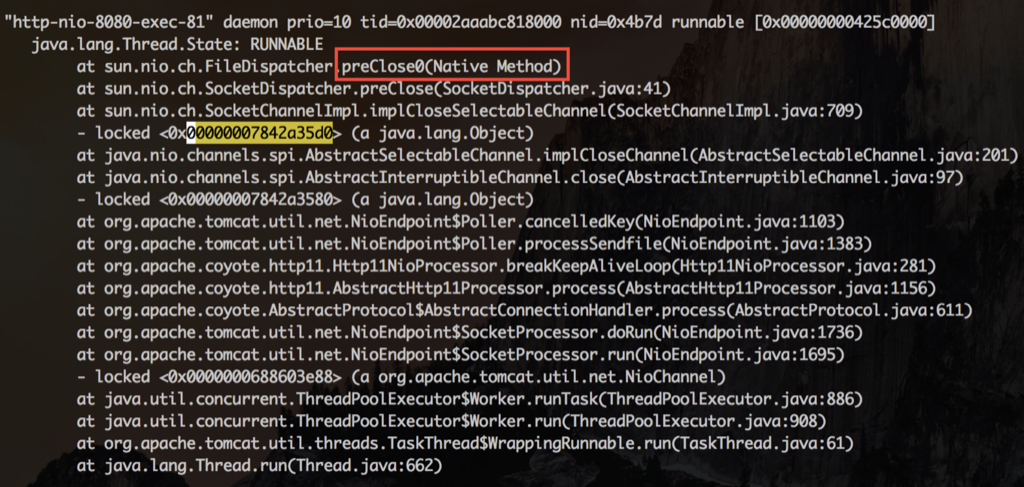

SO_LINGER的单位为秒!在网络环境比较好的时候,例如客户端、服务器都部署在同一个机房,close虽然会被阻塞,但时间极短可以忽略。但当网络环境不那么好时,例如存在丢包、较长的网络延迟,buffer中的数据一直无法发送成功,那么问题就出现了:close会被阻塞较长的时间,从而直接或间接引起NIO的IO线程被阻塞,服务器会不响应,不能处理accept、read、write等任何IO事件。也就是应用频繁出现挂起现象。解决方法就是删掉这个设置,close时立即返回,由操作系统接手后面的工作。 这时会看到如下连接状态 以及对应的堆栈 查看其中一个IO线程等待的锁,发现锁是被HTTP线程持有。这个线程正在执行preClose0,就是在这里等待连接的关闭  每次HTTP线程在关闭连接被阻塞时,同时持有了SocketChannelImpl的对象锁,而IO线程在把这个连接移除出它的selector管理队列时,也要获得同一个SocketChannelImpl的对象锁。IO线程就这么一次次的被阻塞,悲剧的无以复加。有些NIO框架会让IO线程去做close,这时候就更加悲剧了。 总之这里的错误原因有两点:1)网络状态不好;2)错误理解了l_linger 的单位,是秒,不是毫秒。 在这两个原因的共同作用下导致了数据迟迟不能发送完毕,l_linger 超时又需要很久,所以服务会出现一直阻塞的状态。 为什么要有 time_wait 状态TIME-WAIT - represents waiting for enough time to pass to be sure the remote TCP received the acknowledgment of its connection termination request.

短连接的开销用ab通过短连接走 lo 网卡压本机 nginx,CPU0是 ab 进程,CPU3/4 是 Nginx 服务,可以看到 si 非常高,QPS 2.2万 再将 ab 改用长连接来压,可以看到si、sy都有下降,并且 si 下降到短连接的20%,QPS 还能提升到 5.2万 一条连接的开销主要是内存开销(如图,来源见水印),另外就是每个连接都会占用一个文件句柄,可以通过参数来设置:fs.nr_open、nofile(其实 nofile 还分 soft 和 hard) 和 fs.file-max 从上图可以看到: 没有收发数据的时候收发buffer不用提前分配,3K多点的内存是指一个连接的元信息数据空间,不包含传输数据的内存buffer 客户端发送数据后,会根据数据大小分配send buffer(一般不超过wmem,默认kernel会根据系统内存压力来调整send buffer大小) server端kernel收到数据后存放在rmem中,应用读走后就会释放对应的rmem rmem和wmem都不会重用,用时分配用完释放

4 z6 U7 e( b) E" ?5 ?. W8 w

可见,内核在 socket 内存开销优化上采取了不少方法: - 内核会尽量及时回收发送缓存区、接收缓存区,但高版本做的更好

- 发送接收缓存区最小并一定不是 rmem 内核参数里的最小值,实际大部分时间都是0

- 其它状态下,例如对于TIME_WAIT还会回收非必要的 socket_alloc 等对象! d+ [$ H, o$ g' [5 L

可用 local port 不够导致对端time_wait 连接重用进而卡顿案例A进程选择某个端口,并设置了 reuseaddr opt(表示其它进程还能继续用这个端口),这时B进程选了这个端口,并且bind了,如果 A 进程一直不释放这个端口对应的连接,那么这个端口会一直在内核中记录被bind用掉了(能bind的端口 是65535个,四元组不重复的连接你理解可以无限多),这样的端口越来越多后,剩下可供 A 进程发起连接的本地随机端口就越来越少了,这时会造成新建连接的时候这个四元组高概率重复,一般这个时候对端大概率还在 time_wait 状态,会忽略掉握手 syn 包并回复 ack ,进而造成建连接卡顿的现象 结论- 在内存、文件句柄足够的话一台服务器上可以创建的TCP连接数量是没有限制的

- SO_REUSEADDR 主要用于快速重用 TIME_WAIT状态的TCP端口,避免服务重启就会抛出Address Already in use的错误

- SO_REUSEPORT主要用来解决惊群、性能等问题

- 全局范围可以用 net.ipv4.tcp_max_tw_buckets = 50000 来限制总 time_wait 数量,但是会掩盖问题

- local port的选择是递增搜索的,搜索起始port随时间增加也变大$ t( _/ z B3 t+ m( Y1 B& v% q; W, M

参考资料9 [/ i* W4 Z" W0 c

& J& b* q$ f; q

( v- R$ ^* {% l: c$ j

7 Q% |! b; s1 D0 [! X# Linux # TCP # SO_REUSEADDR # ip_local_port_range' G8 x) r$ a1 g& }0 I; j+ M+ Y

- t4 H6 I1 M8 }9 p* d |

|手机版|小黑屋|赛格电脑 华强北 电脑城 南山赛格 龙岗电子世界 龙华电脑城 沙井电脑城 松岗电脑城 pc4g.com

( 粤ICP备16039863号 )

|手机版|小黑屋|赛格电脑 华强北 电脑城 南山赛格 龙岗电子世界 龙华电脑城 沙井电脑城 松岗电脑城 pc4g.com

( 粤ICP备16039863号 )